Parece sonho: tecnologia para identificar crimes antes mesmo de acontecerem, de modo que preveni-los seja possível. Mas, a julgar pelo departamento de marketing de empresas de segurança, a premissa do filme Minority Report, adaptado de um conto do escritor Philip K. Dick, já é realidade.

Diferente da obra de ficção, em que humanos geneticamente modificados antecipam assassinatos e roubos por meio de uma espécie de clarividência, a tecnologia para antever crimes se apoia em inteligência artificial (IA) e big data. No seu modelo mais comum, usam dados históricos de data, horário e regiões de ocorrências, denúncias e prisões. Tudo isso é processado por algoritmos. O resultado são mapas com indicações de quais áreas e em quais momentos o patrulhamento policial deve ser priorizado.

Na verdade, algo semelhante já é feito há décadas por meio de modelos matemáticos e estatísticos. A IA, porém, possui capacidade de processar um volume muito maior. Isso trouxe a promessa de resultados mais precisos. Além disso, desperta nos responsáveis por formular políticas de segurança pública a expectativa de que a tecnologia será capaz de resolver todos os problemas.

Quando se fala de novas tecnologias como reconhecimento facial e plataformas de predição de crimes, é comum os vendedores exagerarem as vantagens e diminuírem as desvantagens. As empresas de tecnologia entendem que entidades públicas, especialmente órgãos policiais, são facilmente seduzidos por hardwares e softwares chamativos

Robert Muggah, diretor de pesquisa do Instituto Igarapé

Ele também é um dos autores de “Future Crime: Assessing twenty first century crime prediction”, publicação que avalia tecnologias do tipo e faz um apanhado de recomendações para que sejam utilizadas de forma eficaz.

“Essas mesmas empresas”, continua Muggah, “muito raramente têm provas científicas concretas do impacto dos seus produtos e raramente publicam exemplos dos efeitos que trazem para além de anedotas simples.”

Isso não impediu que empresas como a PredPol e Palantir, para ficar em dois dos exemplos mais famosos, fossem contratadas para fornecer plataformas do tipo para inúmeras cidades dos Estados Unidos — vale ressaltar que tecnologias semelhantes são empregadas em outros países.

Além da falta de resultados concretos – o que fez com que vários departamentos de polícia de Los Angeles abandonassem o PredPol em 2019 -, o modelo ainda levanta dúvidas sobre a possibilidade reforçar vieses já existentes dentro da atuação de forças de segurança.

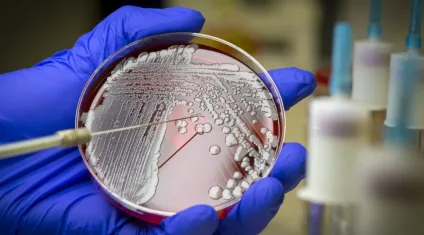

A matemática é simples: os algoritmos tomam decisões a partir de um banco de dados. Mas esse banco de dados traz distorções, então os resultados também serão distorcidos. “Plataformas de predição de crimes devem vir com um aviso de cuidado. Para começar, elas só são tão boas quanto os dados que as alimentam”, afirma Muggah.

Uma pesquisa feita pelo AI Now Institute, instituição que monitora o impacto da inteligência artificial em diversas áreas da sociedade, mostrou que entre 13 jurisdições americanas que usavam plataformas de predição estudadas, nove o faziam a partir de bancos de dados problemáticos.

“Se os próprios dados estão incorretos, isso vai fazer com quê mais recursos policiais sejam destinadas às mesmas comunidades super vigiadas e geralmente visadas por questões raciais”, disse uma das autoras da pesquisa, Kate Crawford, ao Technology Review. “Então o que você fez é uma espécie de lavagem tecnológica onde as pessoas que usam esses sistemas acreditam que eles são de alguma forma mais neutros ou objetivos, mas na verdade eles tem uma espécie de ilegalidade arraigada.”

Há ainda a preocupação entre pesquisadores do tema de que ao indicar áreas mais prováveis de ocorrerem crimes, isso faça com se acentue o perfilamento de suspeitos por parte de forças policiais – algo que já acontece no Brasil no contexto das favelas. Para piorar, também há o medo de criar loops de dados. Isso quer dizer que a partir de momento em que algoritmo de predição de crimes destaca uma região como prioritária para o policiamento, a intensificação do policiamento vai gerar mais ocorrências, o que fará com o algoritmo indique ainda mais policiamento, e assim sucessivamente.

De qualquer forma, esse modelo ainda é fichinha perto de outra proposta mais ousada: prever quem exatamente cometerá um crime.

A China está de olho

A China está um passo à frente do restante do mundo no modo como a tecnologia se integrou ao dia a dia dos seus habitantes – e, óbvio, isso traz consequências claras para a área de segurança. “A China de fato é um país com criminalidade muito baixa e um dos fatores para isso é o uso intensivo de ferramentas de tecnologia para vigiar e monitorar os cidadãos”, diz Felipe Zmoginski, fundador da Inovasia, consultoria especializada no país, e autor do blog Copy From China.

Em nenhum lugar, a vigilância e o monitoramento são tão claros quanto na província de Xinjiang, cuja maior parte da população é da etnia Uyghur e segue a religião muçulmana. Com desejos separatistas, os Uyghur são acusados de cometerem atos terroristas. A partir desse cenário, o governo chinês criou um programa chamado Integrated Joint Operations Platform (IJOP), que usa dados geográficos, de reconhecimento facial, movimentações financeiras, relações interpessoais, compras, entre outros, para identificar comportamentos suspeitos – como a compra de grandes quantidades de fertilizantes químicos que poderiam ser utilizados para fabricar uma bomba, por exemplo.

Se alguém for indicado como suspeito, a polícia é avisada, e essa pessoa é presa e enviada a centros de reeducação política. Um relatório da Human Rights Watch de 2018 destaca a maneira arbitrária dessas prisões, além de ressaltar – de novo – que um perfilamento prévio do governo chinês em relação aos Uyghur distorce os dados e faz com que comportamentos inofensivos sejam tomados como atitudes terroristas.

“A China tem sido cobaia de tecnologias de monitoramento com big data e machine learning”, diz Felipe. De certa forma, ressalta ele, o sistema de social scoring também é uma espécie de predição de crime. O sistema avalia todo o comportamento de um cidadão chinês para estabelecer uma nota. Caso ela seja alta, essa pessoa tem vantagens, como descontos ou facilidades na hora de tirar um visto. Caso seja baixa, por outro lado, ela encontra dificuldades no dia a dia.

Hoje, o social score é opcional, mas há uma expectativa que se torne universal no futuro. “As ferramentas de tecnologia estão evoluindo, então há a tendência de que isso se intensifique”, explica o consultor. “Mas é importante dizer que a realidade cultural da China é diferente da nossa. Enquanto em Los Angeles eles proibiram o reconhecimento facial para policiamento e na Europa há uma enorme discussão sobre privacidade, esse não é o pensamento médio da população na China.”

Mas olhando de fora, é assustador. E antes que tecnologias do tipo sejam implementadas, é preciso explicar de forma clara como funcionam e qual sua eficiência.

“Se desenhadas e implementadas com diligência e cuidado, novas tecnologias podem trazer melhoras positivas para efetividade e eficiência da segurança pública”, afirma Robert Muggah, do Instituto Igarapé. “Mas é preciso ser claro em como essas ferramentas serão usadas, treinamentos regulares no uso das plataformas, salvaguardas éticas para limitar a má utilização, e testes regulares para garantir que estão atingindo seus objetivos.”

Fonte: UOL

Créditos: UOL