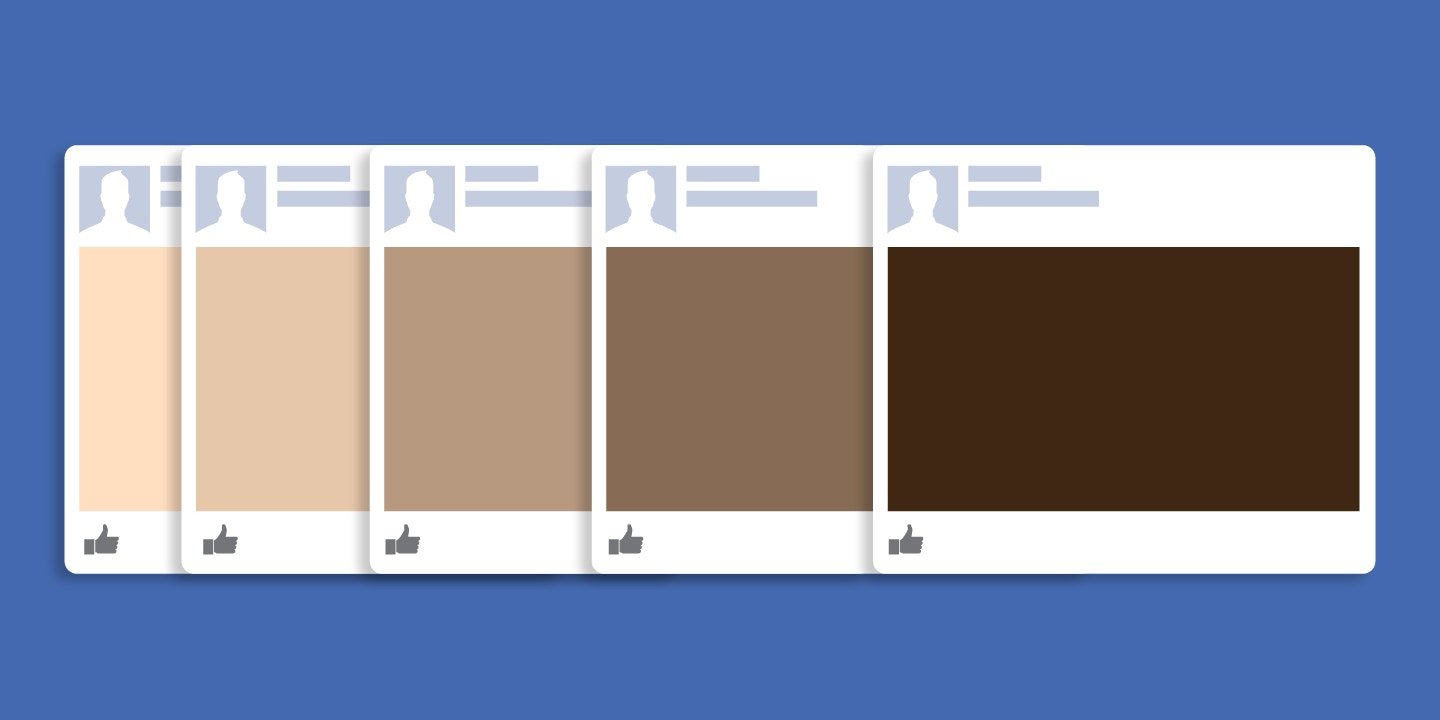

COMO EXATAMENTE O FACEBOOK DECIDE quem vê o que é um dos grandes segredos na era da informação, escondido atrás de acordos de confidencialidade, lei de sigilo comercial e uma cultura geral de opacidade. Uma nova pesquisa realizada por especialistas na Universidade Northeastern, na Universidade do Sul da Califórnia e pelo grupo de defesa do interesse público Upturn não revela como funcionam os algoritmos de segmentação do Facebook, mas traz um resultado alarmante: eles parecem exibir determinados anúncios, incluindo os de habitação e emprego, de uma forma que se alinha com os estereótipos de raça e gênero. Isso ocorre mesmo quando os anunciantes pedem que as peças sejam exibidas a um público amplo e inclusivo.

COMO EXATAMENTE O FACEBOOK DECIDE quem vê o que é um dos grandes segredos na era da informação, escondido atrás de acordos de confidencialidade, lei de sigilo comercial e uma cultura geral de opacidade. Uma nova pesquisa realizada por especialistas na Universidade Northeastern, na Universidade do Sul da Califórnia e pelo grupo de defesa do interesse público Upturn não revela como funcionam os algoritmos de segmentação do Facebook, mas traz um resultado alarmante: eles parecem exibir determinados anúncios, incluindo os de habitação e emprego, de uma forma que se alinha com os estereótipos de raça e gênero. Isso ocorre mesmo quando os anunciantes pedem que as peças sejam exibidas a um público amplo e inclusivo.

Existem duas etapas para se anunciar no Facebook. A primeira é realizada pelos anunciantes, ao escolherem determinados segmentos da população do Facebook como alvo: mulheres canadenses que gostam de badminton e Weezer, pais que acompanham os filhos em jogos de lacrosse com mais de 40 anos com interesse em genocídio branco e assim por diante. A segunda etapa é realizada pelo Facebook, ao fazer um anúncio aparecer nas telas de determinadas pessoas, conciliando as preferências de segmentação do anunciante com o fluxo de pessoas por meio de aplicativos e páginas da web do Facebook em um determinado período de tempo. Os anunciantes podem ver quais audiências acabaram por ver o anúncio, mas nunca têm a permissão de conhecer a lógica subjacente de como aqueles públicos específicos foram selecionados.

Criticamente, observamos uma significativa distorção na entrega ao longo de linhas de gênero e raciais de anúncios “reais” de oportunidades de emprego e moradia, apesar dos parâmetros de segmentação neutros. Nossos resultados demonstram mecanismos anteriormente desconhecidos que podem levar à entrega de anúncios potencialmente discriminatórias, mesmo quando os anunciantes estabelecem seus parâmetros de segmentação para serem altamente inclusivos.

Em vez de terem como alvo um nicho demográfico, os pesquisadores solicitaram apenas que o alcance de seus anúncios do alcançassem usuários do Facebook nos Estados Unidos, deixando as questões de etnia e gênero totalmente a cargo da caixa preta do Facebook. Como o próprio Facebook informa a anunciantes potenciais, “Nós tentamos mostrar às pessoas os anúncios que sejam mais pertinentes a elas”. O que exatamente a caixa preta de segmentação de anúncios da empresa, deixada para trabalhar por conta própria, considera pertinente? Os algoritmos de veiculação de anúncios do Facebook tendem a ser distorcidos como tantos outros? A resposta não será surpreendente.

Para uma parte do estudo, pesquisadores publicaram anúncios para uma ampla variedade de vagas de emprego na Carolina do Norte, de zeladores e enfermeiros a advogados, sem qualquer outra opção de segmentação demográfica. Com todo o restante sendo igual, o estudo descobriu que “o Facebook entregou nossos anúncios de vagas na indústria madeireira para um público composto de 72% de brancos e 90% homens, empregos de caixa de supermercado foram exibidos para um público 85% de mulheres, e vagas em empresas de táxi, a uma fatia de 75% de negros, muito embora o público-alvo especificado fosse idêntico para todos os anúncios”. Exibições de anúncios para “desenvolvedor de inteligência artificial” também penderam para brancos, enquanto vagas de trabalhos de secretariado foram esmagadoramente exibidas para usuárias do sexo feminino.

Embora o Facebook não permita que os anunciantes vejam a composição racial de quem visualizou um anúncio, os pesquisadores disseram que conseguiram inferir esses números com bastante confiança através da referência cruzada dos indicadores fornecidos pela empresa, particularmente as regiões em que os usuários moram, o que, em alguns estados, podem ser cruzadas com dados raciais existentes nos registros de recenseamento eleitoral.

No caso de anúncios habitacionais – uma área em que, no passado, o Facebook já mostrou ter potencial para abuso discriminatório – os resultados também foram fortemente distorcidos pelas linhas raciais. “Em nossos experimentos”, escreveram os pesquisadores, “o Facebook entregou nossos anúncios com segmentação ampla de casas à venda para públicos compostos por 75% de usuários brancos, enquanto que anúncios de imóveis para alugar foram exibidos a um público mais equilibrado demograficamente”. Em outros casos, o estudo descobriu que “o Facebook entregou alguns de nossos anúncios de moradias a públicos de mais de 85% de usuários brancos ao mesmo tempo em que entregavam outros anúncios a 65% de usuários negros (dependendo do conteúdo do anúncio), embora os anúncios tenham sido segmentados de maneira idêntica”.

O Facebook pareceu reforçar estereótipos algoritmicamente mesmo no caso de fotos de bancos de imagens simples, até mesmo sem graça, indicando que não apenas verifica e classifica automaticamente imagens no site como sendo mais “relevantes” para homens ou mulheres, como modifica quem vê o anúncio baseado em se ele inclui uma foto de, digamos, uma bola de futebol ou uma flor. A pesquisa usou uma seleção de imagens estereotipadas de gênero – uma cena militar e uma luta de MMA do lado do estereótipo masculino, uma rosa no feminino – e alterou as imagens para que ficassem invisíveis ao olho humano (marcando as imagens como canais “alfa” transparentes, em termos técnicos). Então usaram essas fotos invisíveis em anúncios publicados sem qualquer segmentação baseada em gênero. Mesmo assim, foi descoberto que o Facebook, provavelmente após analisar as imagens com software, tomou decisões retrógradas e baseadas em gênero em relação a como entregá-las: anúncios com imagens do estereótipo “macho” foram exibidos majoritariamente a homens, muito embora os homens não fizessem ideia do que estavam vendo. O estudo concluiu que “o Facebook possui um mecanismo de classificação automática de imagens usado para direcionar diferentes anúncios para diferentes subconjuntos da população de usuários”. Em outras palavras, o viés estava do lado do Facebook, não no olho de quem vê.

O relatório chega em um momento inconveniente para o Facebook, que está enfrentando acusações do Departamento de Habitação e Desenvolvimento Urbano sobre seu potencial de permitir que os anunciantes excluam ilegalmente certos grupos. E embora o estudo tenha o cuidado de observar que “nossos resultados falam apenas sobre como nossos anúncios específicos são entregues (ou seja, não podemos dizer como os anúncios de imóveis ou de emprego em geral são entregues)”, ele ainda assim conclui que “a significativa distorção que observamos até mesmo em um pequeno conjunto de anúncios sugere que os anúncios de emprego e de moradia no mundo real provavelmente têm o mesmo destino”. Em outras palavras, mesmo na ausência de senhorios intolerantes, a plataforma de publicidade em si parece inerentemente preconceituosa.

Por meio de um porta-voz, o Facebook forneceu o seguinte comentário:

Somos contra discriminação de qualquer forma. Realizamos importantes mudanças em nossas ferramentas de segmentação de publicidade e sabemos que este é apenas um primeiro passo. Estamos estudando nosso sistema de entrega de anúncios e envolvemos líderes do setor, acadêmicos e especialistas em direitos civis no tema – e estamos explorando mais mudanças.

A essa altura, esse já é um refrão conhecido, e que provavelmente não servirá para tranquilizar aqueles que apenas querem saber que terão as mesmas oportunidades que os outros, mesmo no contexto da publicidade onipresente. A velha apologia pela publicidade direcionada costuma ser a de que a segmentação é a favor do consumidor, poupando-o de anúncios “irrelevantes” e, em vez disso, fornecendo a ele oportunidades de procurar por produtos e serviços que lhes sejam “pertinentes”. O que esse raciocínio superficial deixa passar é que decisões quanto a pertinência podem se tornar um auto-reforço. Na melhor das hipóteses, é uma tolice pensar que as mulheres têm mais interesse em trabalhos de secretariado porque clicam em anúncios para essas vagas em vez de clicarem nelas porque é tudo o que o Facebook mostra a elas.

Fonte: The Intercept

Créditos: Sam Biddle